Epstein e il primo cittadino di New York, un racconto su un’immagine generata dall’IA (e sul nostro lavoro di svelamento)

Tra i documenti resi noti dal Dipartimento di Giustizia degli Stati Uniti, comprendenti 3,5 milioni di file riguardanti Jeffrey Epstein e la sua collaboratrice Ghislaine Maxwell, si trova anche un’email inviata nel 2009 da Peggy Siegel, un’associata di Epstein.

Nel messaggio si accenna a un after party in onore del film Amelia, diretto dalla regista indiana Mira Nair, al quale avrebbero partecipato, oltre alla cineasta, anche Jeff Bezos, fondatore di Amazon, e l’ex presidente degli Stati Uniti Bill Clinton.

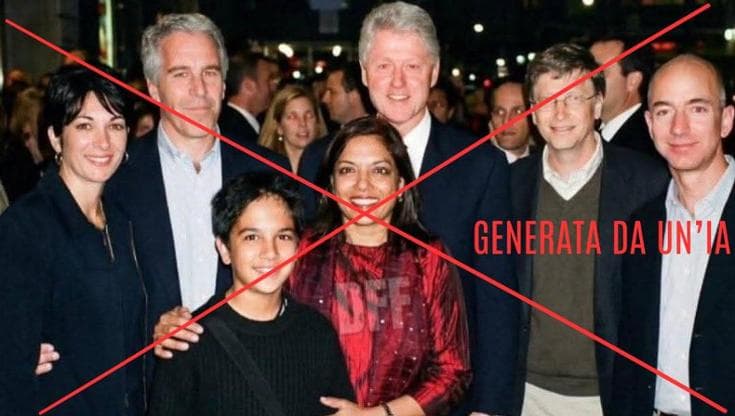

L’origine della foto falsa

Quella email, insieme al contesto descritto, ha ispirato un account satirico su X a creare un’immagine prodotta tramite intelligenza artificiale.

La foto falsa ritrae Mira Nair con suo figlio – l’attuale sindaco di New York Zohran Mamdani – quando era ancora un bambino. Intorno a loro si trovano Epstein, Maxwell, Clinton, Bezos e Bill Gates.

La scena è ambientata all’aperto, in strada, e richiama l’immagine di un evento pubblico, come una prima di un film o un incontro legato al mondo del cinema. L’account satirico ha accompagnato la diffusione dell’immagine falsificata con la frase: “Trucchi del mestiere per diventare un politico di successo in America”.

Sull’immagine è presente in trasparenza il logo “DFF”, associabile all’account satirico che l’ha creata.

Una semplice verifica della fonte su X permetterebbe di risalire all’origine del contenuto e di confermare che si tratta di un profilo che, come indicato nella propria biografia, satirizza sia la sinistra che la destra attraverso video e meme “di alta qualità” prodotti con intelligenza artificiale.

Questo aspetto offre un contesto chiaro che consente di interpretare l’immagine come un controverso contenuto satirico, capace di generare disinformazione.

Il sostegno dei complottisti

Questa immagine è stata in effetti interpretata da alcuni come autentica e condivisa come se avesse una base reale. Tra coloro che ne hanno approfittato c’è Alex Jones, noto conduttore radiofonico statunitense per la diffusione di teorie del complotto e le sue posizioni nell’estrema destra.

In un post su X, Jones ha presentato l’immagine come una notizia fresca, affermando che nuovi documenti legati a Epstein collegherebbero direttamente Zohran Mamdani e sua madre al criminale condannato per abusi sessuali, alla sua collaboratrice e a Gates, Clinton e ad altre personalità pubbliche.

A sostegno di tali affermazioni, Jones ha utilizzato l’immagine generata dall’account satirico, facilitando la sua diffusione sui social.

Come riconoscere una foto generata dall’IA?

Il caso solleva una questione più ampia: in assenza di un marchio identificativo come quello presente sulla foto falsa, come sarebbe stato possibile accertare l’autenticità di un’immagine di questo tipo?

La fotografia appare tecnicamente convincente. Le mani dei soggetti sembrano complete e proporzionate, senza anomalie nel numero delle dita, che spesso vengono considerate un segnale rivelatore delle immagini generate dall’IA.

Anche le persone sullo sfondo risultano credibili e presentano dettagli coerenti con l’epoca e con la tecnologia utilizzata per catturare la scena, incluso il tipico effetto degli occhi rossi causato dal flash nelle foto notturne della fine degli anni Duemila.

La prima incongruenza

Dal punto di vista anagrafico, i protagonisti sembrano corrispondere all’età che avrebbero avuto nel 2009.

L’unica incongruenza evidente riguarda Zohran Mamdani che, nato nel 1991, all’epoca avrebbe avuto circa diciotto anni, mentre nell’immagine appare come un bambino.

Questo scarto temporale costituisce un primo elemento dissonante e solleva un dubbio ragionevole sulla veridicità dello scatto.

Come funziona l’IA generativa

Per comprendere come vengano create immagini di questo tipo, è fondamentale considerare il punto di vista di chi le elabora. Gli autori conoscono i meccanismi dei modelli di intelligenza artificiale generativa e sanno che, per ottenere una fotografia credibile ambientata in un determinato periodo storico, i soggetti devono apparire coerenti con il loro aspetto in quell’epoca.

Bezos, Gates, Clinton, Epstein, Maxwell e Mira Nair sono quindi rappresentati con tratti conformi al loro aspetto attorno al 2009.

Essendo personaggi pubblici, esiste un’ampia documentazione fotografica risalente a quegli anni. È plausibile che l’autore abbia utilizzato immagini d’archivio, scatti singoli dei vari soggetti, per fornire al modello di intelligenza artificiale riferimenti visivi coerenti.

A partire da questi materiali, attraverso un prompt testuale, è stato certamente richiesto al sistema di generare una scena unica: una fotografia di gruppo che includa tutti i soggetti forniti come riferimento, collocati in un contesto plausibile e coerente. Il risultato è un’immagine realistica, capace di confondersi con un documento autentico.

L’unico soggetto per il quale non esiste una quantità comparabile di immagini pubbliche è Zohran Mamdani da bambino.

In quel periodo della sua vita non era una figura pubblica e la disponibilità di fotografie riconducibili a lui è limitata a pochi scatti emersi solo in seguito.

La ricerca su Google

Proprio su questo elemento si è concentrata la nostra indagine, alla ricerca della “prova” definitiva.

Per verificare quali materiali di partenza potessero essere stati impiegati, è stata effettuata una semplice ricerca su Google utilizzando parole chiave mirate come “Younger Zohran Mamdani 2009” o “Zohran Mamdani 2009 child”, limitando i risultati alla sezione immagini. Tra i contenuti restituiti compaiono, in effetti, alcune fotografie che ritraggono Mamdani con la madre quando era bambino.

Uno di questi risultati è particolarmente significativo. Nell’immagine, la madre indossa un vestito rosso, mentre il bambino ha una maglia nera e una borsa a tracolla: gli stessi abiti visibili nell’immagine generata con l’intelligenza artificiale.

La foto che abbiamo trovato, risalente agli anni Duemila, è autentica: è stata pubblicata di recente anche da un giornale rispettato e accreditato come The Telegraph, in un articolo dedicato a immagini private dell’attuale sindaco di New York.

La corrispondenza visiva degli abiti di Mamdani e Nair suggerisce che quello scatto possa aver costituito uno dei materiali di partenza utilizzati per la creazione dell’immagine artificiale, con il ragazzo e la madre riposizionati in una posa diversa e inseriti in una scena pubblica.

La prova definitiva

Tuttavia, la foto originale, che presenta solo Mamdani e la madre, non elimina ogni “dubbio”: la presenza di transenne e l’ambientazione notturna rinforzano l’idea di un evento ufficiale, come una prima di un film.

Teoricamente, questo scenario appare compatibile con il contenuto dell’email del 2009 rinvenuta nei documenti legati a Epstein e con il contesto evocato dall’immagine. In astratto, si potrebbe persino avanzare l’ipotesi che si tratti di uno scatto della stessa serata.

Per verificare questa supposizione, la nostra attenzione si è rivolta a una delle più grandi banche dati fotografiche al mondo, Getty Images.

Effettuando una ricerca per nome di Mira Nair e consultando le immagini più datate, emergono fotografie che la ritraggono proprio insieme al figlio in una situazione pubblica, con gli stessi abiti presenti nell’immagine trovata su Google.

La prova decisiva è fornita dai metadati ufficiali: Getty attesta che gli scatti risalgono al 14 giugno 2004. Le immagini documentano la presenza di madre e figlio a una proiezione del film Fahrenheit 9/11.

Si tratta quindi di un evento diverso, collocato cinque anni prima rispetto al 2009 e privo di qualsiasi legame con il contesto evocato dall’email associata a Epstein.

Questo riscontro consente di escludere in modo definitivo l’ipotesi che l’immagine “di gruppo” circolata online, con Epstein e Maxwell, rappresenti una fotografia autentica della stessa occasione.

L’importanza delle fonti

Il confronto con archivi fotografici certificati dimostra che la scena è stata ricostruita artificialmente a partire da materiali reali, decontestualizzati e riassemblati.

Il caso evidenzia come, per smascherare immagini generate dall’intelligenza artificiale e diffuse come documenti autentici, sia necessario combinare strumenti classici del giornalismo, come il fact checking e la consultazione delle fonti, con una conoscenza di base dei meccanismi dell’IA generativa.

In un contesto informativo sempre più affollato di contenuti sintetici, è su questo terreno che si gioca una parte fondamentale della distinzione tra informazione verificata e disinformazione.

I commenti sono chiusi.