CES 2026, Lisa Su e la corsa al calcolo per l’IA: AMD sfida Nvidia con OpenAI e un robot italiano

LAS VEGAS – Presso il Venetian, l’hotel che cerca di ricreare l’atmosfera di Venezia con canali e gondolieri, il discorso di Lisa Su, CEO di AMD, ha segnato l’inizio del CES 2026, la fiera leader a livello mondiale per l’elettronica di consumo.

Il suo intervento è avvenuto poche ore dopo quello di Jensen Huang, CEO di Nvidia, che al Fontainebleau Theatre, a breve distanza lungo la Strip, ha attratto oltre duemila persone per illustrare la sua visione riguardo a chip, guida autonoma e robotica, riassunta nell’espressione “intelligenza artificiale fisica”.

I due leader aziendali, così vicini, hanno cercato di delineare la direzione dell’industria nel prossimo ciclo di investimenti sull’intelligenza artificiale.

Lisa Su, CEO di AMD

L’IA come priorità fondamentale

Su ha iniziato senza fronzoli: “Non sorprenderà nessuno che questa serata sia completamente dedicata all’intelligenza artificiale”, ha affermato dal palco, definendo l’evento come una vetrina della potenza computazionale di AMD.

Alle sue spalle scorrevano frasi come “L’IA è ovunque” e “L’IA è per tutti”.

Poco dopo ha specificato l’importanza strategica dell’argomento: l’intelligenza artificiale è “la tecnologia più rilevante degli ultimi cinquant’anni” ed è “indubbiamente la priorità principale per AMD”. Secondo le sue stime, entro i prossimi cinque anni cinque miliardi di persone utilizzeranno l’IA quotidianamente.

La richiesta di calcolo e l’arrivo di OpenAI

“Non abbiamo nemmeno lontanamente sufficiente potenza di calcolo per realizzare tutto ciò che potremmo,” ha affermato Su, richiamando un problema ben noto alle grandi aziende e ai professionisti del settore.

Subito dopo l’annuncio di una nuova GPU – la MI440X, una versione della serie MI400 progettata per essere installata direttamente nei data center aziendali e indicata come dieci volte più potente rispetto a chip precedenti come il MI355X – Su ha cambiato tono, chiamando a sorpresa sul palco Greg Brockman, co-fondatore e presidente di OpenAI, noto come stretto e fidato collaboratore di Sam Altman.

L’intervento di Greg Brockman, simbolo dell’accordo strategico con OpenAI

L’ingresso di Brockman è stato accolto dalla CEO di AMD con una battuta scherzosa. “Ogni volta che ci incontriamo, mi dici che hai bisogno di maggiore potenza di calcolo,” ha osservato Su, collegando il racconto di AMD alla crescente necessità di risorse computazionali da parte delle grandi aziende impegnate nello sviluppo dell’intelligenza artificiale.

Lisa Su insieme a Greg Brockman di OpenAI

“Ciò che desideriamo dall’IA non è solo un incremento della produttività, ma la capacità di risolvere problemi che oggi sembrano impossibili: curare malattie, rivoluzionare l’istruzione e sviluppare nuove fonti di energia,” ha affermato Brockman. “Per farlo, abbiamo bisogno di tutta la potenza di calcolo possibile. Il limite attuale non è la nostra immaginazione, ma quanti chip siamo in grado di inserire nei data center.”

L’intervento di Brockman non è stato affatto casuale. Lo scorso ottobre OpenAI ha siglato un accordo strategico di grande importanza con AMD, impegnandosi ad acquistare una quantità significativa di chip per l’intelligenza artificiale, pari a circa 6 gigawatt di capacità complessiva.

L’accordo include anche l’assegnazione a OpenAI di warrant, strumenti finanziari che conferiscono il diritto di acquistare in futuro azioni AMD a un prezzo già stabilito. In questo caso, i warrant possono tradursi nell’acquisto fino a 160 milioni di azioni, una quota potenziale intorno al 10 per cento del capitale, legata al raggiungimento di specifici obiettivi di performance.

L’operazione ha rafforzato notevolmente la posizione di AMD nel mercato dell’intelligenza artificiale, in competizione con Nvidia, garantendo prospettive di introiti significativi negli anni a venire. OpenAI si assicura la possibilità di entrare nel capitale di AMD, mentre si impegna ad acquisti su larga scala di chip a partire dal 2026, necessari per espandere la propria capacità di calcolo.

“Abbiamo applicato i nostri modelli di IA per progettare i nuovi chip MI450,” ha detto Brockman ai partecipanti del CES. “L’IA ha scoperto ottimizzazioni che ai nostri ingegneri avrebbero richiesto mesi. È un circolo virtuoso: utilizziamo l’IA per costruire hardware migliore, che a sua volta consente di sviluppare un’IA ancora più potente.”

Da ChatGpt alla crescita esponenziale

Brockman ha anche discusso del successo di ChatGpt, definendolo un fenomeno che è esploso all’improvviso, frutto però di “sette anni di lavoro”. Il cofondatore di OpenAI ha spiegato che attualmente le persone utilizzano i prodotti dell’azienda per molto più che una semplice ricerca testuale, trovando modi personali e quotidiani per trarne vantaggio. “Quello che stiamo realmente osservando sono miglioramenti tangibili nella vita delle persone,” ha dichiarato.

A sostegno di questa affermazione ha citato il settore sanitario, sostenendo che in alcuni casi ChatGpt ha contribuito a salvare delle vite.

Brockman ha raccontato un episodio interno all’azienda: una dipendente di OpenAI, dopo aver utilizzato il sistema, avrebbe persuaso il marito a tornare in ospedale per un dolore alla gamba inizialmente sottovalutato. Secondo Brockman, si è poi rivelato essere una trombosi venosa profonda.

Su ha chiesto a Brockman di spiegare perché la richiesta di potenza di calcolo sia diventata così urgente. E lui ha risposto che negli ultimi anni OpenAI ha triplicato annualmente il proprio fabbisogno di calcolo, seguendo un ritmo di crescita costante. Un’espansione che, ha aggiunto Brockman, si è riflessa anche nei ricavi dell’azienda, aumentati con la stessa progressione.

Oltre l’IA generativa: spazio e mondo fisico

Durante il keynote di Lisa Su, è salita sul palco anche Fei-Fei Li, una delle figure più influenti nella ricerca sull’intelligenza artificiale e attualmente alla guida di World Labs, startup da lei cofondata che sviluppa modelli di “intelligenza spaziale”, capaci di comprendere e interagire con il mondo fisico in tre dimensioni.

Lisa Su insieme a Fei-Fei Li

L’intervento della scienziata ha spostato l’attenzione oltre l’IA generativa tradizionale, verso sistemi capaci di percepire lo spazio, il movimento e il contesto. “Stiamo entrando in una nuova fase dell’intelligenza artificiale, in cui le macchine non si limiteranno a leggere e scrivere, ma inizieranno a vedere e agire nel mondo reale,” ha affermato Li, collegando questa evoluzione a robotica, automazione e scienza.

Su ha raccolto il punto, inserendolo nella strategia industriale di AMD: “Per rendere possibile questa nuova generazione di AI servono piattaforme di calcolo potenti, aperte e affidabili,” ha dichiarato, sottolineando il ruolo dell’hardware come fattore abilitante per la ricerca e le applicazioni concrete.

Il dialogo tra le due ha rafforzato uno dei messaggi chiave del keynote: la prossima ondata dell’intelligenza artificiale non sarà solo una questione di modelli, ma di come l’IA sarà in grado di operare nel mondo fisico, grazie a una convergenza sempre più stretta tra ricerca accademica e industria.

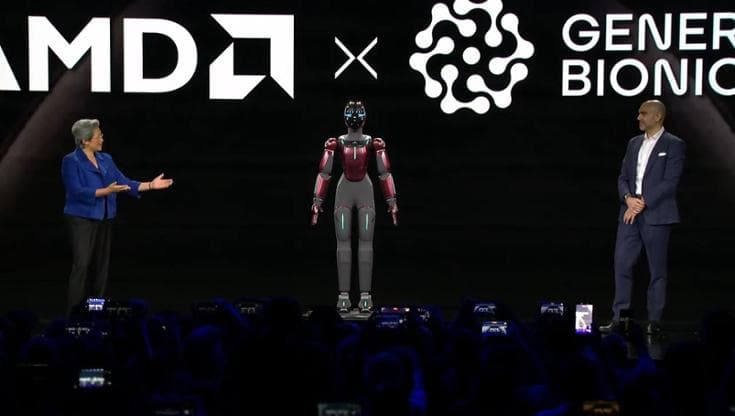

Il contributo italiano all’IA fisica: il robot di Generative Bionics

Per discutere di IA fisica, Lisa Su ha invitato sul palco un italiano: Daniele Pucci, ingegnere robotico e CEO di Generative Bionics, la startup nata dall’Istituto Italiano di Tecnologia che sviluppa robot umanoidi intelligenti destinati ad operare nel mondo reale.

Lisa Su insieme a Daniele Pucci, CEO di Generative Bionics

Pucci ha spiegato che il suo lavoro richiede prestazioni elevate “che non possono aspettare il cloud”, evidenziando la necessità di accedere alle GPU più potenti di AMD per alimentare i sistemi di robotica avanzata.

Sul palco ha quindi fatto il suo ingresso GENE.01, un robot umanoide costruito da Generative Bionics in grado di muoversi e percepire l’ambiente circostante, dotato di sensori tattili e meccanismi di equilibrio ispirati alla locomozione umana. Sarà prodotto, annuncia Pucci, nella seconda metà del 2026.

Su ha accolto con entusiasmo la presentazione del robot italiano, affermando che “osservare queste applicazioni di IA fisica qui al CES evidenzia quanto sia fondamentale il calcolo ad alte prestazioni per portare l’intelligenza artificiale fuori dai data center e nel mondo reale.”