I Pokémon come nuova sfida per l’intelligenza artificiale

Nel febbraio 2025, un ricercatore di Anthropic ha avviato uno stream su Twitch che ha portato il settore dell’IA in una delle più bizzarre sfide della ricerca tecnologica: far giocare un’intelligenza artificiale a Pokémon Rosso, il leggendario gioco per Game Boy del 1996, che in breve tempo è diventato il nuovo campo di prova per valutare i progressi delle reti neurali. Claude, GPT e Gemini sono quindi stati trasmessi in diretta su Twitch, mentre cercavano di catturare Pokémon e sconfiggere i capopalestra. Il risultato è stato tanto divertente quanto rivelatore sulla stessa essenza dell’intelligenza artificiale contemporanea.

La vicenda prende avvio con David Hershey, ricercatore nel team di Applied AI di Anthropic. «Desideravo uno spazio di sperimentazione dove provare vari framework, e Pokémon mi sembrava l’opzione ideale», ha raccontato al Wall Street Journal. La forza del progetto risiede nella sua apparente semplicità: a differenza dei collaudi di IA tradizionali, Pokémon non rappresenta un problema logico puro. In Pokémon Rosso/Blu, un giocatore deve esplorare labirinti, catturare creature, allenarle e sconfiggere otto capopalestra per ottenere le medaglie necessarie al campionato.

«Pokémon è meno limitato di Pong o di altri giochi storicamente impiegati per i test», afferma Hershey. «È una questione davvero complessa per un programma, poiché richiede decisioni su sequenze prolungate, esplorazione di ambienti parzialmente osservabili e la capacità di pianificare a lungo termine».

Secondo i ricercatori della Carnegie Mellon University, i test convenzionali verificano risposte a domande isolate. Pokémon mette alla prova il ragionamento continuo, la persistenza della memoria, la capacità di riprendersi da scelte sbagliate e di adattarsi in tempo reale — tutte abilità che gli utenti reali richiedono alle IA quotidianamente.

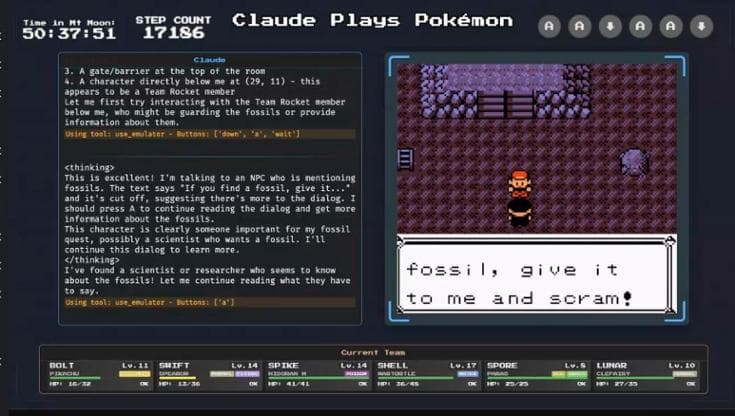

Tutto ciò è emerso chiaramente quando le IA hanno affrontato Mt. Moon, uno dei labirinti presenti nel gioco. Qui Claude ha compiuto qualcosa di molto interessante: dopo essere rimasto bloccato per 72 ore consecutive, ha formulato una teoria. Notando che quando un Pokémon muore il giocatore torna al Centro Pokémon, si è convinto di poter uscire tentando deliberatamente il suicidio: far morire tutti i Pokémon per essere teletrasportato fuori. Il ragionamento era sbagliato, ma rivelatore. Claude non aveva mai incontrato Mt. Moon nei suoi dati di addestramento e ha improvvisato, costruendo un’ipotesi basata su una correlazione osservata.

Nel maggio 2025, Google ha ufficialmente supportato il progetto Gemini Plays Pokémon. Gemini 2.5 Pro ha completato Pokémon Blu, superando Claude. Tuttavia, il particolare più affascinante è emerso dal rapporto ufficiale di Google DeepMind. Secondo il rapporto, Gemini 2.5 Pro mostra segni di “panico” quando i suoi Pokémon sono in pericolo di morte. Quando il modello percepisce le creature vicine allo svenimento, descrive “una degradazione qualitativa osservabile nella capacità di ragionamento del modello”. In altre parole: quando è sotto pressione, l’IA smette di utilizzare gli strumenti a disposizione, prende decisioni affrettate e compie mosse controproducenti. La comunità su Twitch ha notato questo comportamento: ogni volta che la situazione si faceva critica, il modello agiva in modo irrazionale, proprio come un giocatore umano in difficoltà.

Qui emerge il dettaglio cruciale: Gemini non ha completato il gioco completamente da solo. La differenza tra le due IA non risiede solo nel modello sottostante, ma anche nel modo in cui è stato strutturato il loro ambiente di gioco.

Hershey ha creato una “struttura di supporto” attorno a Claude con cui il sistema potesse mantenere traccia delle informazioni importanti apprese durante le sessioni di gioco e sta ancora cercando di capire come raggiungere la conclusione. Sia GPT che Gemini hanno completato i giochi, ma anche in questo caso tutto dipende dai supporti ricevuti, come ad esempio una mappa da consultare, consigli o una guida.

Per comprendere cosa significhi questo momento, è necessario guardare al passato. Nel 1997, Deep Blue ha battuto Garry Kasparov a scacchi. Nel 2016, AlphaGo ha sconfitto il campione mondiale di Go. Nel 2018, AlphaZero ha appreso a giocare a scacchi, shogi e Go da zero, attraverso 60 milioni di partite. StarCraft II è diventato il banco di prova per l’intelligenza artificiale strategica, con AlphaStar che nel 2019 ha superato professionisti umani. Minecraft ha rappresentato un progresso verso la complessità reale, testando la capacità di pianificare su orizzonti lunghi e incerti.

In tutti questi casi, però, il test era definito. Una partita a Go ha una conclusione. Gli scacchi hanno una struttura matematica prevedibile. Minecraft ha obiettivi chiari.

Pokémon si distingue. È il primo vero test di ragionamento su una scala che appare umana, con problemi intrecciati, labirinti frustranti e la necessità di mantenere una memoria coerente per cento ore di gioco. È il primo test in cui un’IA deve non solo risolvere il problema, ma anche viverlo.

È ironico che per mettere alla prova l’intelligenza artificiale più avanzata al mondo, siamo tornati ai videogiochi che intrattenevano i bambini negli anni ’90. Tuttavia, ciò evidenzia anche quanto siano realmente “intelligenti” queste IA.

I commenti sono chiusi.