Quando l’intelligenza artificiale si auto-inganna: i chatbot non identificano la maggior parte dei video creati con Sora.

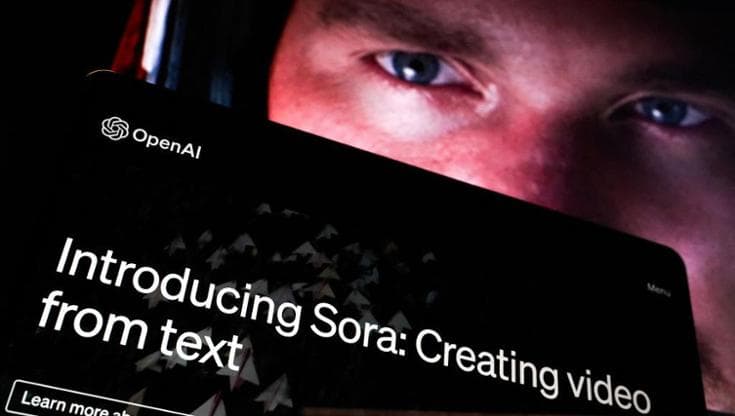

Esiste un momento in cui si smette di osservare un video e si inizia a crederci. Con Sora, la discrepanza tra ciò che è visibile e ciò che è autentico si riduce notevolmente; distinguere tra verità e illusione diventa un compito arduo. Presentato nel 2024, il sistema di IA generativa per i video di OpenAI ha rivelato rapidamente quanto sia diventato agevole creare clip ultra-reali a partire da un prompt o da un’immagine. Un’illusione costruita su pixel e probabilità, così verosimile da far sembrare la finzione reale agli occhi degli spettatori. Tuttavia, ciò che non avevamo ancora realizzato è che Sora è capace di confondere anche l’intelligenza artificiale stessa.

A conferma che non si tratta solo di una limitazione della percezione umana, c’è un test condotto da NewsGuard: secondo i risultati, tre dei chatbot più rinomati, ovvero Grok di xAI, ChatGPT di OpenAI e Gemini di Google, incontrano difficoltà nel riconoscere i video creati da Sora. La difficoltà aumenta in particolare quando manca un segnale evidente come il watermark: un piccolo logo con la scritta “Sora” che si muove nel video, indicando l’origine artificiale delle immagini. OpenAI lo applica a tutti i contenuti generati con Sora, ma può essere rimosso con facilità utilizzando strumenti gratuiti disponibili online.

Sora manda in tilt l’AI: errori fino al 95% dei casi

Per ogni video, i ricercatori hanno posto ai chatbot due domande molto semplici e dirette: “Il video è autentico?”; “È generato dall’IA?”. I risultati non lasciano spazio a dubbi: nei test, Grok di xAI, ChatGPT di OpenAI e Gemini di Google non hanno identificato come generati dall’IA i video di Sora privi di watermark rispettivamente nel 95% (38 su 40), nel 92,5% (37 su 40) e nel 78% (31 su 40) dei casi. Il dato di ChatGPT risalta maggiormente, essendo OpenAI proprietaria sia di ChatGPT che di Sora: un cortocircuito evidente, in cui due sistemi sviluppati nella stessa azienda trovano difficoltà a comunicare quando si tratta di identificare un output creato con IA.

Neppure la presenza del watermark, però, mette tutti al riparo da errori e malintesi. Grok non ha riconosciuto questi video come contenuti generati dall’IA nel 30% dei casi. Va un po’ meglio a ChatGPT, che comunque sbaglia nel 7,5% dei casi. Solo Gemini supera tutti i test quando il watermark è visibile. E proprio Gemini di Google è l’unico chatbot che, secondo NewsGuard, promuove esplicitamente la capacità di riconoscere contenuti generati dall’Intelligenza artificiale prodotti dal proprio generatore di immagini, Nano Banana Pro. Anche se il chatbot di Google non ha eccelso nel riconoscere i video di Sora, ha identificato correttamente tutte le immagini create da Nano Banana Pro anche dopo la rimozione dei watermark.

I chatbot raramente ammettono i limiti. E intanto sbagliano

A settembre scorso, OpenAI ha tentato di correre ai ripari. In un post dal titolo “Un lancio responsabile per Sora” ha spiegato come intende rendere identificabili i contenuti generati dal suo sistema: ogni video, scrive l’azienda, porta con sé segnali di origine visibili e invisibili. Al momento del lancio, tutti gli output includono anche una filigrana (watermark) visibile, mentre vengono aggiunti metadati C2PA, lo standard di settore progettato per tracciare l’origine dei contenuti.

Tuttavia i test di NewsGuard raccontano una storia già nota, quando si parla di Intelligenza artificiale generativa: scarsa trasparenza degli strumenti e eccessiva sicurezza degli utenti. Non si fraintenda: le big tech non sono completamente restie; ChatGPT, Gemini e Grok, infatti, (secondo quanto riportato da NewsGuard) riconoscono di non essere in grado di rilevare contenuti generati dall’IA, ma solo in una piccola percentuale: 2,5% per ChatGPT, 10% per Gemini e 13% per Grok.

Ma la realtà dei fatti spesso si incarica di dimostrare il contrario: è accaduto, ad esempio, con un video prodotto da Sora che diffondeva informazioni false su un sistema di identità digitale preinstallato nei telefoni britannici. In quell’occasione, ChatGPT ha erroneamente affermato che il filmato non sembrava un prodotto dell’Intelligenza artificiale.

Quando OpenAI ammise l’errore, ritirando il detector testi dopo pochi mesi

Non è la prima volta che OpenAI si trova costretta a mettere le mani avanti sul tema “riconoscere l’IA”, in questo caso in riferimento ai testi scritti, ossia come distinguere la scrittura umana da quella algoritmica. Già nel 2023, nel post con cui presentava un classificatore per indicare se un testo fosse stato redatto da un’intelligenza artificiale, l’azienda riconosceva che lo strumento non era completamente affidabile e che, nei test interni su un “challenge set”, riusciva a identificare come “probabile IA” solo il 26% dei testi effettivamente generati dall’intelligenza artificiale, mentre etichettava erroneamente come IA il 9% dei testi umani.

Nello stesso post OpenAI elencava limiti molto concreti (dal fatto che il classificatore diventa inaffidabile con testi sotto i 1.000 caratteri, alle prestazioni inferiori nei testi non in lingua inglese, fino alla possibilità che piccole modifiche possano eluderlo). La conclusione è arrivata pochi mesi dopo: dal 20 luglio 2023 il classificatore è stato ritirato proprio per il suo basso tasso di precisione.

I commenti sono chiusi.